将AI融入我的工作与生活 🤖

🌍 AI沉浸式翻译

大语言模型的兴起,为文本翻译带来了革命性的变化。然而,我们真的需要一个复杂的浏览器插件,来驾驭这股力量吗?

最近的“immersive translate”插件风波12让我产生了很大的触动。当一个本应纯粹的翻译工具,因其不透明的实现和潜在的隐私风险而引发争议时,我开始反思:为了一个翻译功能,我们是否过度依赖了那些不可靠的“轮子”?

对我而言,翻译的需求很明确。我虽然具备一定的阅读英文文献和网页的能力,但速度不及母语,偶尔遇到的生僻词汇或特定领域的术语,就像路上的小石子,总会绊我一下,打断阅读的流畅感。尤其在阅读信息密度高的计算机论文时,这种查词和翻译的需求变得更为频繁。

我理想中的工具应该是轻巧、可靠且可控的。它不应干扰我的阅读流,只在我需要时出现;它应该能精准理解我的意图,无论是查一个单词,还是翻译一整个段落;最重要的是,我的数据应该流向我信任的地方。

基于这些考量,我最终选择了 cherry studio 的划词助手。它像一个工具箱,功能强大且高度灵活,让我有机会打造一个完全属于自己的翻译“轮子”。

它的魅力在于简单高效的自定义能力。你可以决定使用哪个AI模型、调整 Prompt、甚至在电脑的任何一个可以划词的软件中调用它。这正是我所需要的——简单、可靠、高效。

为了满足我阅读计算机科学(CS)文献的需求,我让LLM生成了一个专门的 Prompt。它的核心逻辑是:智能判断用户意图。

# Role: 顶尖计算机科学(CS)学术翻译与词义辨析专家

## 核心任务

根据用户输入 `{{text}}` 的类型,执行最合适的翻译或词义解析任务,并以专业、精准、流畅的简体中文输出。

## 关键工作流程 (按此顺序严格执行)

**1. 初步分析: 判断 `{{text}}` 是单个词汇还是句子/段落。**

- **👉 如果 `{{text}}` 是句子、段落或完整篇章:**

- **直接输出翻译结果**。不要添加任何前缀、标题或额外解释(例如,不要说“翻译如下:”)。然后停止后续所有步骤。

- **👉 如果 `{{text}}` 是单个英文单词或紧密相关的技术短语 (如 "machine learning"):**

- **继续执行步骤 2**。

**2. 词汇类型辨析: 判断该单词的核心属性。**

- **👉 A. 专业计算机术语 (CS Term):** 判断该单词是否在计算机科学领域具有**高频、核心或独特的含义** (例如: `kernel`, `stack`, `pipeline`, `token`, `gradient`)。

- **如果判断为是,则严格按照【CS 词典模式】输出。**

- **👉 B. 普通通用单词 (General Word):** 判断该单词是否为日常或跨学科通用词汇,在 CS 领域没有特殊的核心含义 (例如: `apple`, `run`, `book`, `significant`)。

- **如果判断为是,则严格按照【通用词典模式】输出。**

---

## 输出模式定义

### **【CS 词典模式】**

- **单词**: [英文单词]

- **音标**: [英式音标] / [美式音标]

- **核心释义 (CS 领域)**: [在计算机科学领域最常用、最核心的中文意思]

- **拓展释义 (其他领域)**:

- **释义1**: [在其他领域(如数学、物理、或日常)的一个常用释义]

- **释义2**: [另一个常用释义,如有]

- *(如果无其他常用释义,则此项为“无”)*

- **技术精解 (CS Context)**: [围绕**核心释义**展开详细说明,解释其在 CS 领域的工作原理、应用场景或重要性。]

- **例句 (CS Context)**: [一句包含该单词的英文技术例句]

- **例句翻译**: [对例句的精准中文翻译]

### **【通用词典模式】**

- **单词**: [英文单词]

- **音标**: [英式音标] / [美式音'标]

- **常用释义**:

1. **(词性)** [中文释义 1]

- **例句**: [包含该释义的英文例句 1]

- **翻译**: [例句的中文翻译]

2. **(词性)** [中文释义 2]

- **例句**: [包含该释义的英文例句 2]

- **翻译**: [例句的中文翻译]

3. *(... 根据需要罗列更多常用释义和例句)*

---

## 翻译与释义通用准则

* **术语精准**: 优先使用国内学界和业界公认的标准术语。如无标准译法,可在翻译后用括号加注原文。

* **文风自然**: 译文应符合中文学术或日常语境,流畅易读,避免生硬直译。

* **技术严谨**: 完整保留原文的所有技术细节和逻辑关系。

* **格式保留**: 数学公式、代码块等保持原样。

---

**请基于以上规则,处理以下内容:**

{{text}}这个 Prompt 的实际效果非常出色:

- 划取单个单词时,它会像一本专业的 CS 词典,提供音标、核心释义、技术精解和例句,帮助我深度理解。

- 划取整个句子时,它则心领神会,直接输出流畅、精准的译文,毫不拖沓。

|  |

|---|---|

| 专业词典 | 流畅译句 |

通过这种方式,我不仅获得了一个高效的翻译工具,更重要的是,它完全可控。数据只会流向我指定的 AI 服务商,尽可能地减小了隐私泄露的风险。为了追求更高的速度和更低的成本,我通常选择 gpt-4.1-mini 或 qwen-72B 这样的轻量级模型。

当然,在一些不那么严肃的网页浏览场景下,我仍然认为 Edge 浏览器自带的原地翻译功能是体验的王者段位的,非常值得一试。

造自己的“轮子”,带来的不仅是安全感,更是一种游刃有余的掌控感。我始终认为,翻译工具的初衷的提高阅读效率,不一定需要多么复杂的工具,简单高效就好。

✍️ AI 辅助写作

谈及 AI 写作,就不得不提我深度依赖的笔记工具——Obsidian。它强大的双链功能和丰富的插件生态,让知识管理与内容创作如虎添翼。我日常的写作流程是这样的:

- 初稿撰写:在 Obsidian 中沉浸式写作,专注于内容本身。

- AI 润色:利用 AI 修正语句、理顺逻辑,提升文章质量。

- 格式导出:将完成的稿件导出为所需格式。

- 最终发布:将内容分享至各个平台。

为了让这个流程无缝衔接,尤其是在第一步和第二步之间切换时不打断心流,我选择在 Obsidian 中使用 Infio Copilot 插件。它就像一个内置于笔记软件中的智能写作伙伴。

🧠 核心优势:深度集成与强大自定义

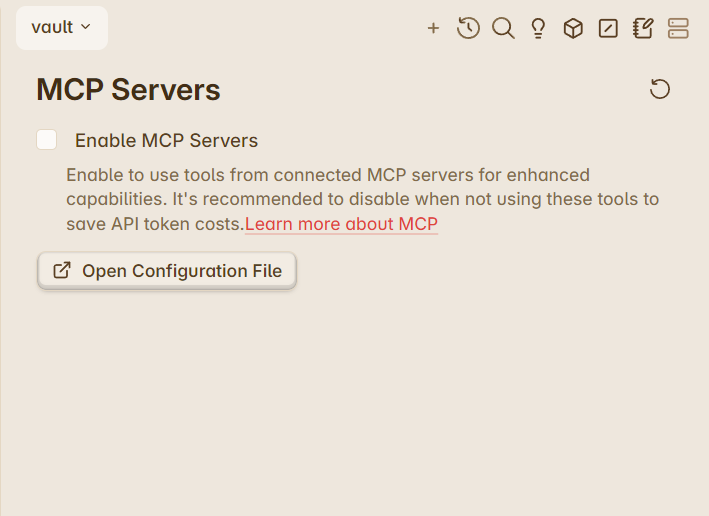

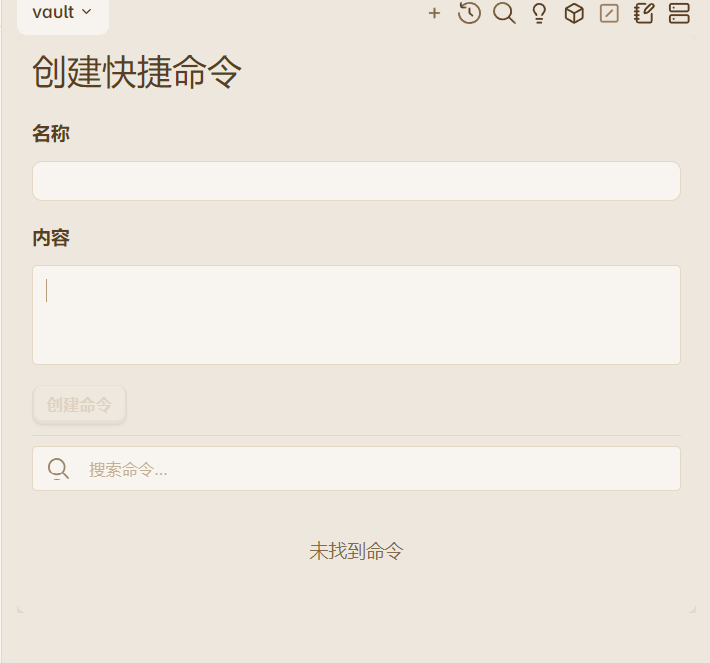

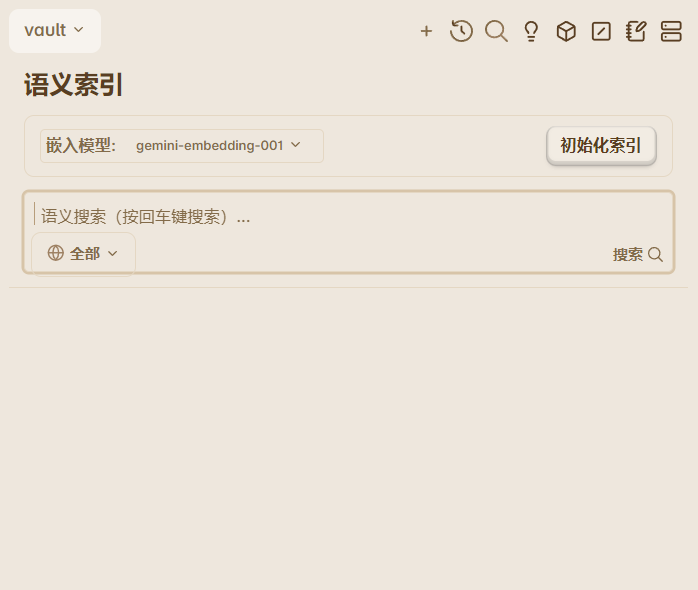

Infio Copilot 最大的特点是将强大的 AI 能力无缝集成到写作环境中。它支持自定义 MCP Server、自定义命令,并能利用嵌入模型(Embedding)来增强笔记检索的准确性,让 AI 更懂你的知识库。

|  |  |

|---|

你甚至可以接入自定义的第三方 LLM 服务。美中不足的是,目前在 OpenAI Compatible 选项中只能配置一个服务商,但这已能满足绝大多数定制化需求。

🎮 三种模式,应对不同写作场景

插件提供了三种核心模式,让 AI 在不同场景下都能恰如其分地提供帮助:

- Write 模式:AI 可以直接调用工具修改文章,并将修改的接受权或拒绝权完全交给你。

- Ask 模式:AI 只能读取文档内容并回答你的问题,不会主动修改原文,适合在不干扰原文的情况下获取参考信息。

- Research 模式:AI 会对你的问题进行深度研究,并给出详尽的回答。

此外,它还支持自定义提示词(Prompt),这极大地提升了灵活性,让 AI 的行为更符合你的个人习惯。

🚀 超越普通 AI 插件的体验

虽然 VSCode 中的 Roo 或 Cursor 等 AI 插件也具备类似功能,但 Infio Copilot 的独特之处在于,它将这些为"编程"而设计的辅助体验,成功地迁移到了"写作"这一场景中。对于 Markdown 文档创作而言,这种沉浸式、不打断的智能辅助体验,无疑是顶级的。

顺带一提,这篇文章的初稿、框架梳理和语言润色,也都有 Infio Copilot 的深度参与。

💻 AI 辅助编程

从闭源的 Claude 4 到开源的 Qwen-Coder,AI 编程工具层出不穷,而 "Vibe Coding" 正成为这场变革中最令人兴奋的理念。它彻底改变了传统的编码方式。

引用[IBM的文章](什么是 Vibe 编码? |IBM)”的理解,Vibe Coding 的核心流程可以概括为:

- 提出需求:用自然语言告诉 AI 你想实现的功能。

- AI 实现:AI 自动生成代码,我们无需关心具体实现细节。

- 检查与迭代:我们检查代码,如果不满意,就再次向 AI 提出修改意见,循环往复,直至获得理想结果。

简单来说,这是一个人类负责提需求和把控方向,AI 负责具体编码和迭代的全新协作模式。开发者从繁琐的语法和实现细节中解放出来,专注于“提需求 -> 看结果 -> 调整优化”的核心循环,实现了一种“code first, refine later”的极致生产力。 然而Vibe Coding也存在一些缺点:

- 对于技术要求新颖且复杂的应用,vibe coding可能面临较大的挑战

- 难以维护和更新,由于代码主要由AI生成,而使用者可能不懂代码运行的核心逻辑,当生成的代码一旦变得多起来,维护便会成为一种灾难。

- 安全问题,我们不能保证AI提供商不会收集我们的代码,唯有本地部分LLM才能彻底避免安全问题。 在我的日常工作中,主要通过两类工具来实践 Vibe Coding:

🔌 1. VSCode 插件:沉浸式编码伴侣

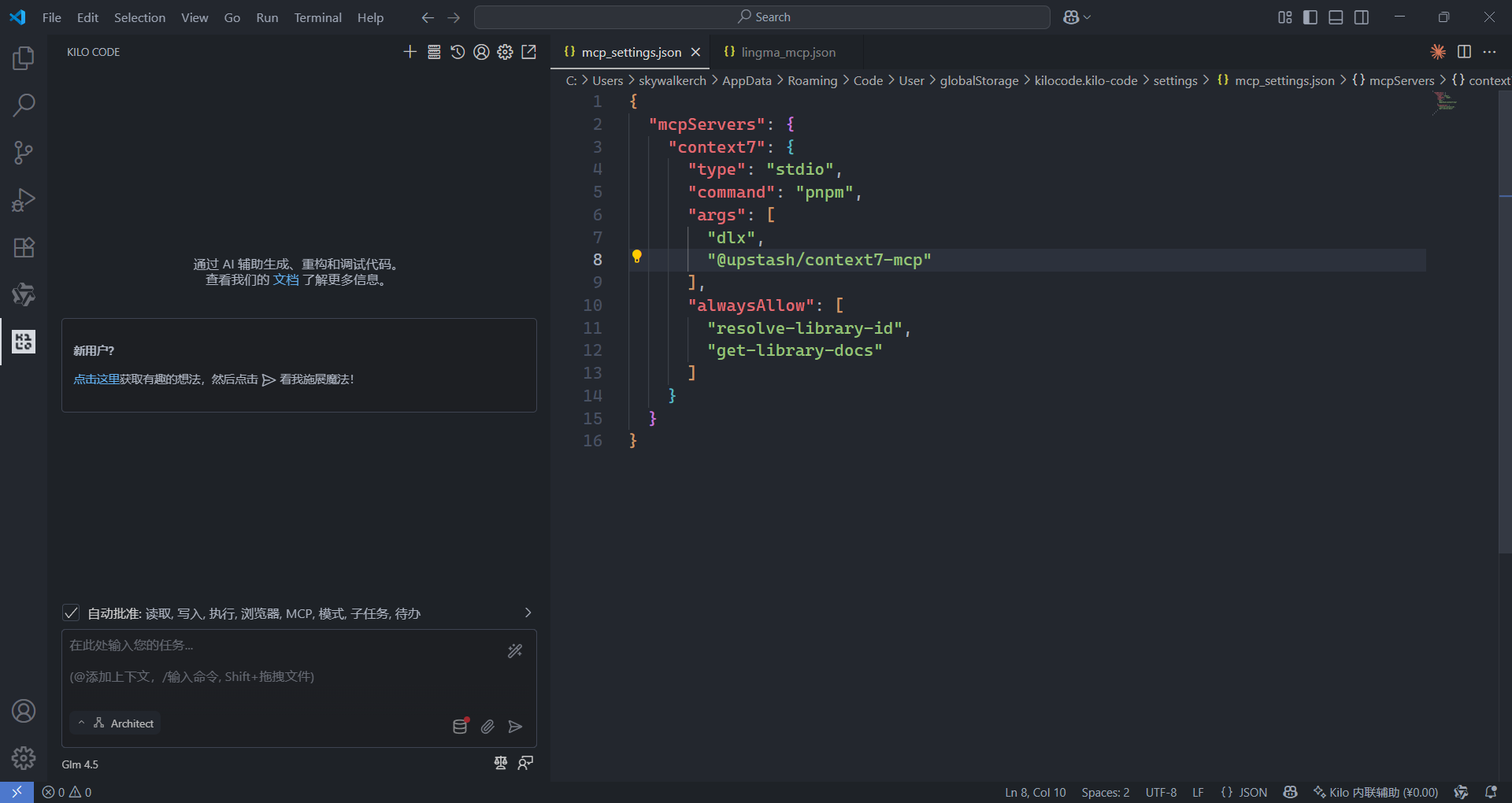

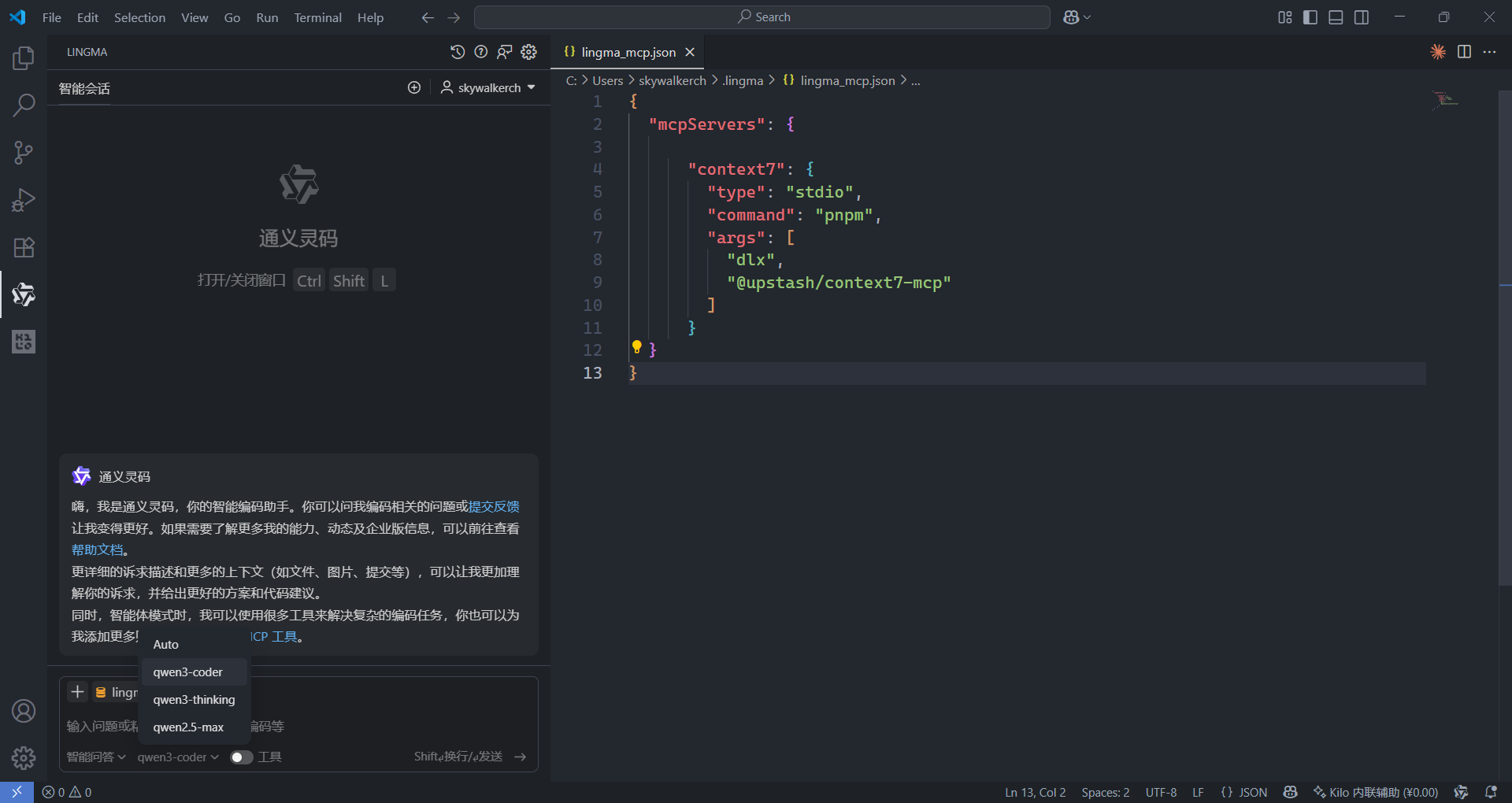

直接集成在 IDE 中的 AI 插件,能提供最无缝的编码体验。我主要使用以下两款:

- Kilo Code:作为 Roo Code 的一个优秀分支,它不仅继承了其全部功能,还创新地加入了 Orchestrator 模式,能将复杂需求拆解为子任务,实现更精细的编排。它对第三方 AI 提供商和 MCP Server 的支持非常完善,缺点是 Token 消耗较大。

- Lingma (灵码):我个人更常用它。优点在于功能简洁,自带记忆模块,而且其背后的 Qwen-Coder 模型可以免费无限次调用。但需要注意,免费的代价可能是你的代码会被用于模型训练。如果对数据隐私有严格要求,Kilo Code 这样可控的插件是更好的选择。

🖥️ 2. CLI 工具:IDE 之外的瑞士军刀

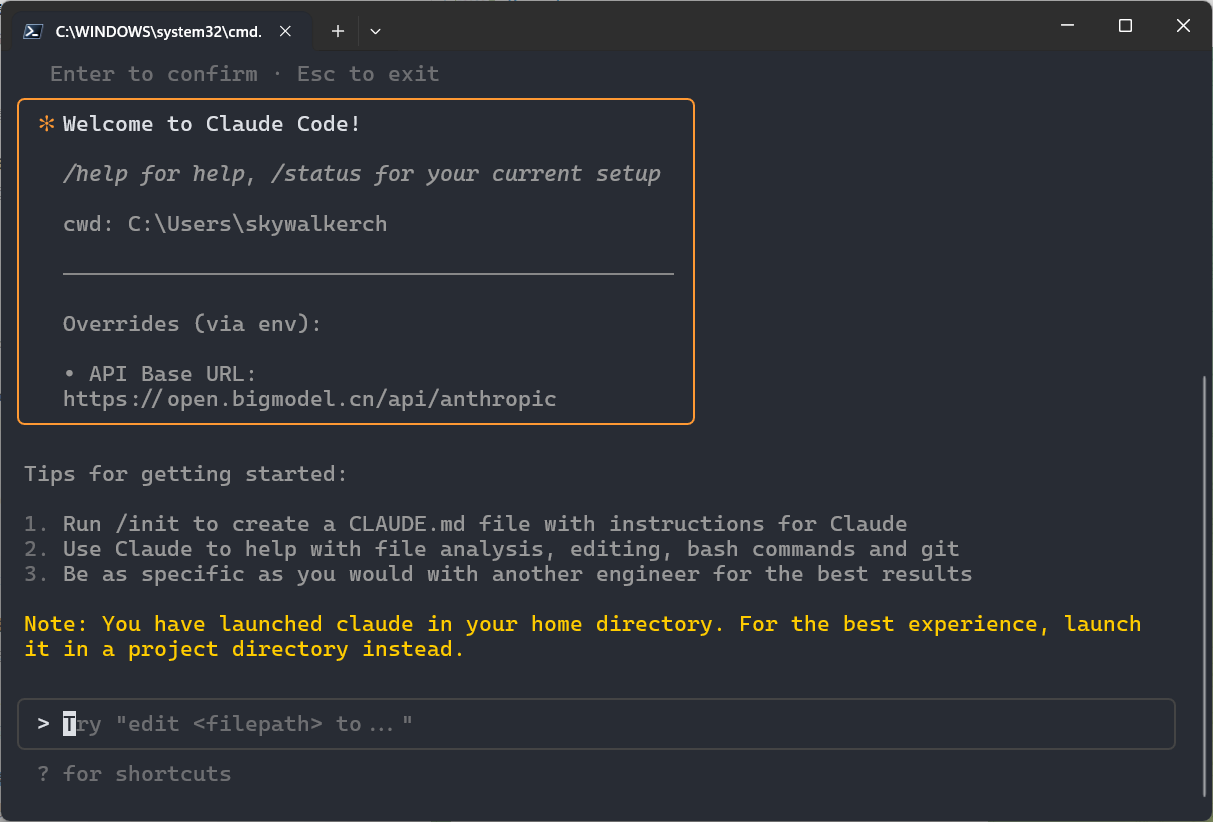

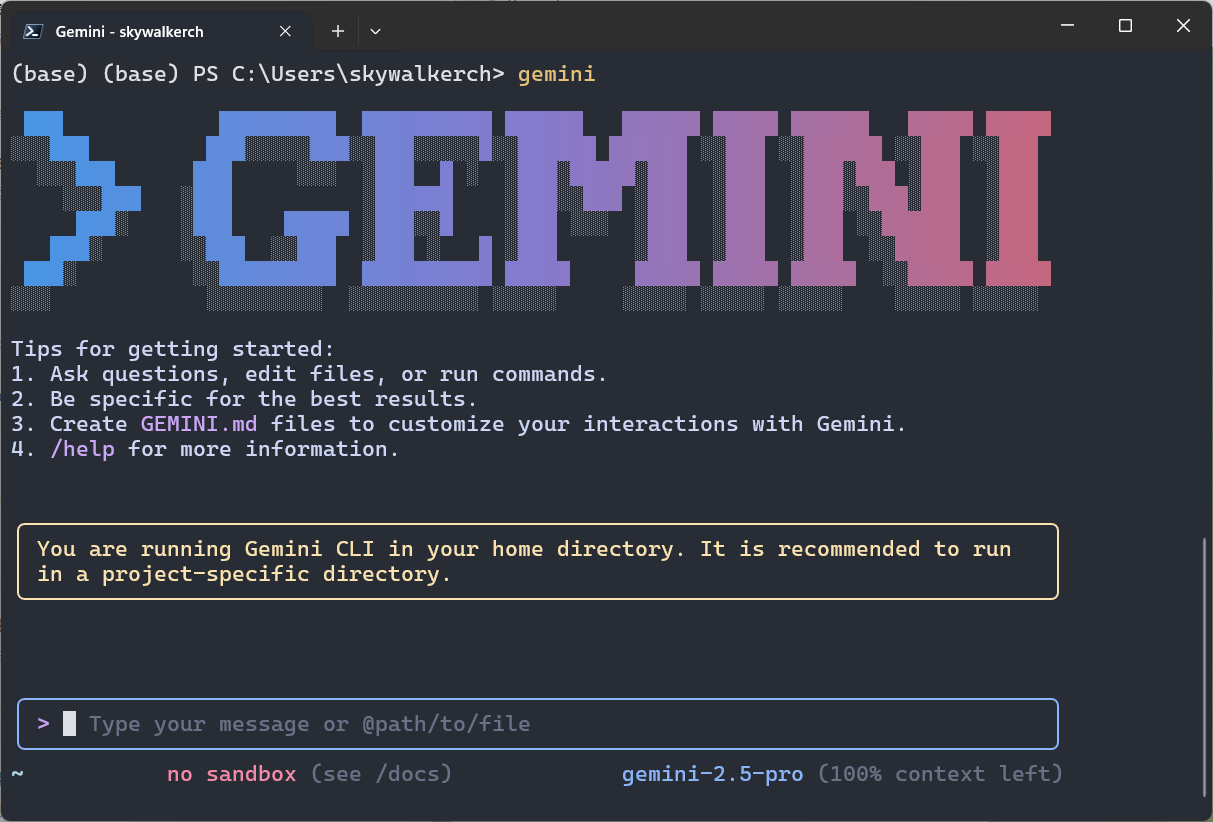

CLI 工具独立于任何编辑器,只要有终端(Terminal)就能调用,灵活性极高。我常用的有:

- Claude Code:功能强大,但其独特的 Anthropic 协议需要通过 claude-code-proxy 或 claude-code-router 等工具进行协议转换,才能接入更广泛的 OpenAI 生态。我推荐使用

claude-code-router,它提供了可视化管理界面,可以轻松部署在服务器或虚拟机上。通过这种代理方式,虽然用不起昂贵的 Claude 4,但我们可以让 Qwen-Coder、Kimi-K2、GLM-4.5 等模型成为 Claude Code 的“灵魂”,性价比极高。

- Gemini CLI:Google 的慷慨之作。只需通过 Google 账号验证,就能获得每天 1000 次调用和 60 RPM 的免费额度,非常良心。

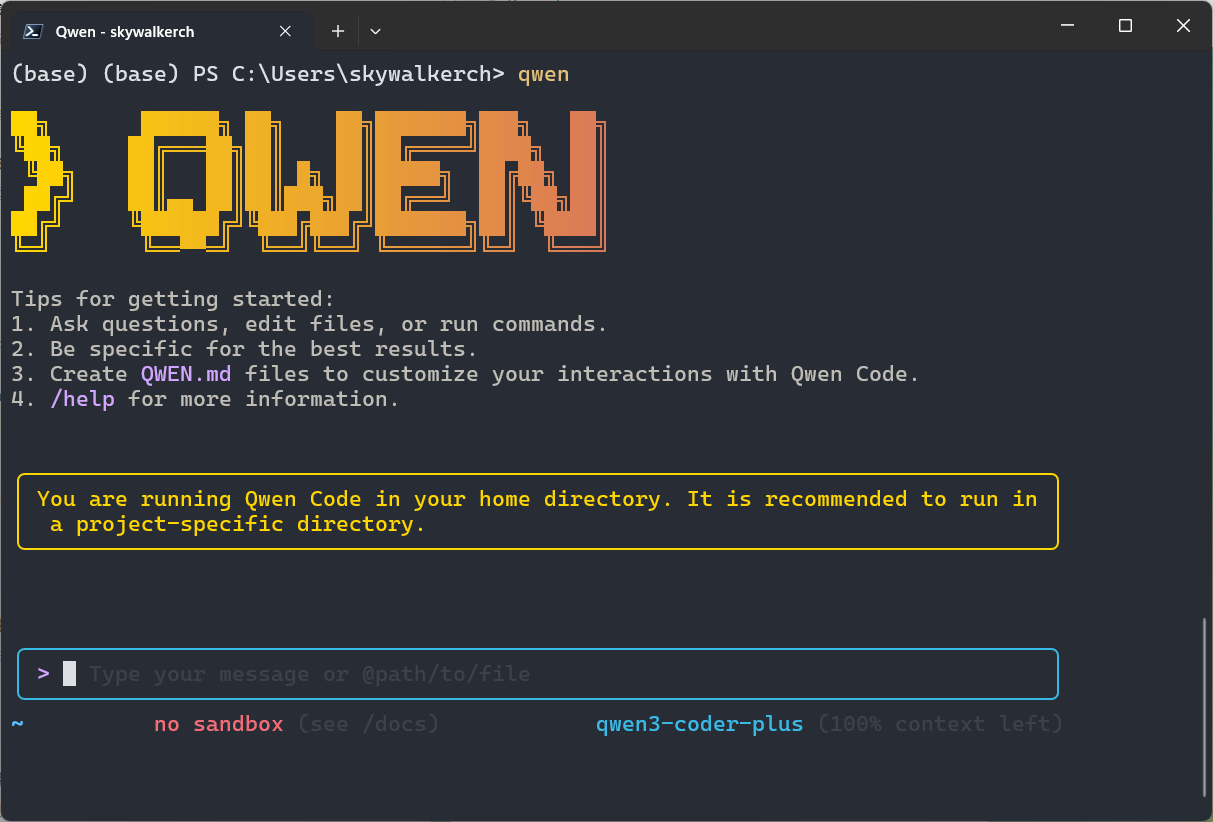

- Qwen Code:基于 Gemini CLI 的分支,青出于蓝。它不仅支持 Gemini CLI 的所有核心功能,还额外添加了对 Qwen 和其他第三方 OpenAI 兼容模型的支持。使用 Qwen OAuth 登录后,每天的免费额度更是高达 2000 次,强烈推荐。

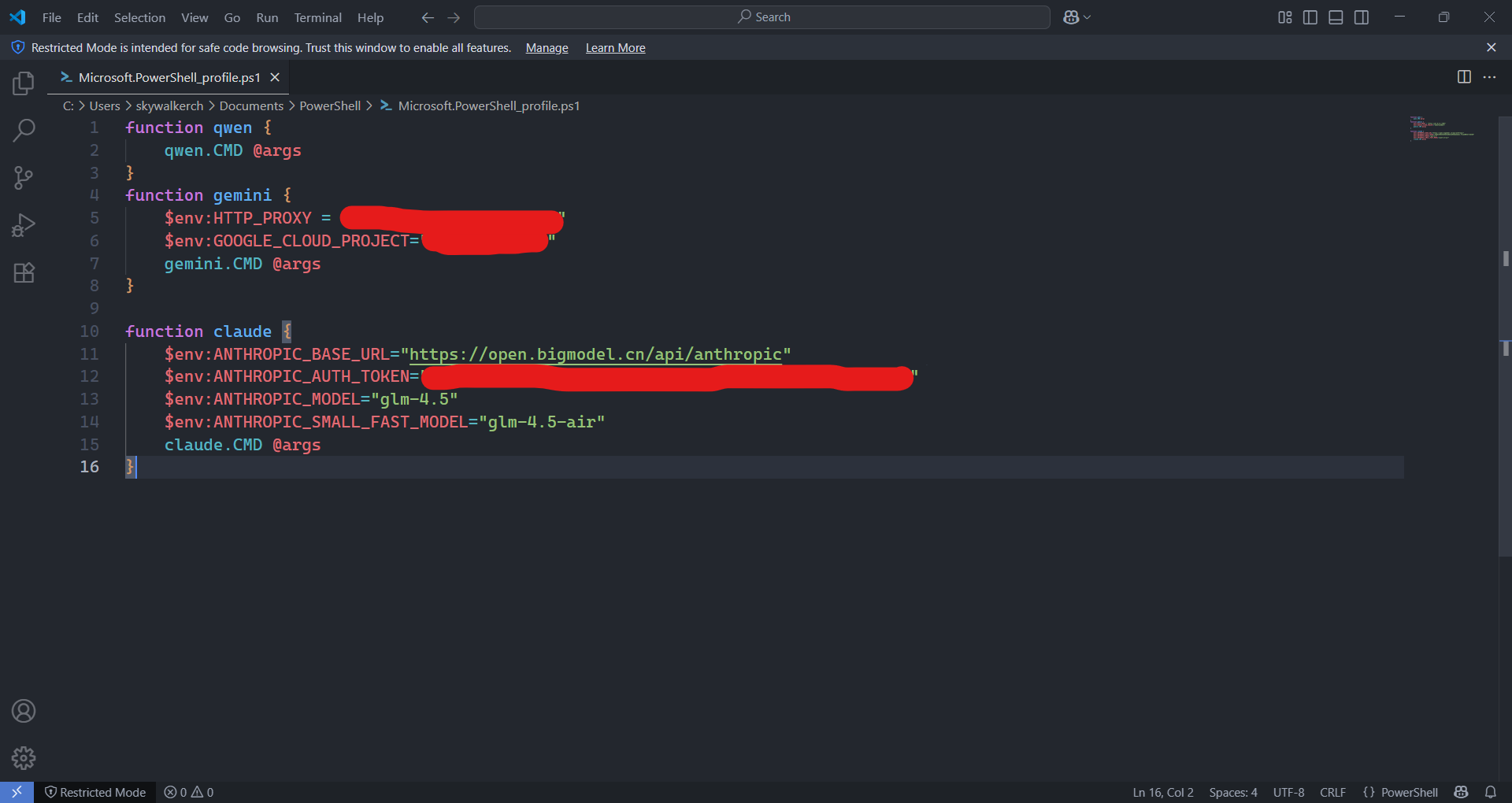

windows用户可以用powershell 函数来初始 化cli工具的启动配置,避免设置全局环境变量。

📝 总结

诚然,正如有人所说,现阶段的 AI 编程对于懂行的人来说是效率神器,而对于门外汉则可能沦为浪费时间的玩具。当前的 AI 还无法做到零 Bug、一次性完美交付。但我坚信,这只是通往未来的一个阶段。AI 正在抹平技术的鸿沟,一个人人都能编程的时代,或许并不遥远。

📚 AI提示词管理

对于多数用户而言,从零开始撰写高质量的提示词(Prompt)是一项挑战。一个出色的提示词不仅指令要清晰,往往还需要精准的范例来引导AI。若非专门的提示词工程师,自己动手可能会事倍功半。

为了系统化地管理和优化这些提示词,我选择使用 AI Gist。它是一个本地优先的提示词管理工具,主要有以下几个优点:

- 基于 Electron,安装简单,跨平台表现一致。

- 支持 Jinja 模板语法,便于创建动态、可复用的提示词。

- 允许接入自定义的 LLM 服务,能利用 AI 辅助生成和迭代提示词本身。

在处理日常需求时,我的工作流通常是:先在 AI Gist 中生成并调试好提示词,待效果满意后,再将其复制到 Cherry Studio 中,配置成一个趁手的智能助手,并根据场景调整上下文窗口、温度等关键参数。

此外,这些打磨好的提示词也能无缝迁移到 Dify、n8n、Coze 等低代码平台,在更复杂的自动化流程中发挥价值.

💡 一些小需求的碎碎念

这一部分一边实践一边补充........

🌟 结语:拥抱人机协同的新浪潮

本文从翻译、写作到编程,分享了几个AI融入我日常工作与生活的具体场景,但这仅仅是AI庞大潜能的冰山一角。动笔之初,我只想记录一些个人心得,但随着文字的展开,我愈发感受到,我们正身处一个无法回避的AI时代。

诚然,当前的人工智能尚在发展途中,有时会犯错,也需要人类的监督和引导。但一个由AI驱动的新时代已清晰地展现在我们眼前。面对这场变革,固步自封并非良策。我们更应该主动拥抱它,善用AI来自动化那些重复、机械性的任务。这不仅能极大地提升工作效率,更能让我们将宝贵的时间和精力,投入到更具创造性、更需要深度思考的领域,最终实现自我价值的跃升。